そのADAS/AD技術はきちんと作動しているか:神奈川工科大学・定量評価手法の確立とその意義

ADAS/ADの作動時、運転をシステムに委ねるドライバーはどのように感じているのか?神奈川工科大学ではADAS/ADの“運転スキル”を定量評価しようという研究が進められている。

TEXT:髙橋一平(Ippey TAKAHASHI) PHOTO:市 健治(Kenji ICHI) FIGURE:KAIT

カメラから見た景色がどのように映っているのか正確にわからない......これは驚きだった。

神奈川工科大学ではADAS/AD(AD=自動運転)における実車評価手法を研究している※。これを手がけるのは同大の井上秀雄教授で、SIPのDIVPプロジェクトにおけるキーパーソンでもある。そこで今回の取材は、同プロジェクトについての解説を伺うところから始まった。

ADAS/ADの作動領域拡大においてボトルネックのひとつとなっているのが、車載用途のカメラが持つ性能だ。近年、IT系や半導体関連の企業といった、いわゆる自動車分野以外の企業によるAI(人工知能)を用いた自動運転技術の発表が相次いでおり「運転という行為を楽しめるのもあとわずか」という論調がまるで確定した事実であるかのように独り歩きしているが、AIを含めコンピューター技術が自動運転を実現(しかもこの論調が示唆するのはドライバーレスの完全自動運転だ)に充分な能力を(仮に)すでに獲得していたとしても、いまはまだカメラの能力が足りていないというのが現実なのだ。

ここでいうカメラの能力とは解像度のこと。自動運転には少なくとも8MP(メガピクセル)が必要と言われるが、一般的な量産の市販車に採用できるような車載用途のカメラモジュールが実現するのは数年後とされる(2020年12月現在)。車載用途のカメラモジュールには、自動車向け電子部品の信頼性試験基準(AEC=Automotive Electronics Councilによる規格など)をクリアする必要があるが(加えて言うならコスト要件も)、これはカメラモジュールで捉えた画像を処理するイメージプロセッサーと呼ばれるSoC(System on Chip)も同様。半導体にとってきわめて厳しいといえる温度と振動条件にさらされるなかで安定した動作を保証しながら、映像という膨大な情報をリアルタイムで処理するだけのパフォーマンスを確保することもまた容易ではない。

このようにカメラの能力が足りないというところまではわかっていたつもりだったのだが(それも解像度に限ったハナシだが)、カメラから見た景色がどのように映っているのか正確にわからないということは、足りない能力がどの程度足りないのかということがはっきりとわからないということである。カメラの能力の問題ははるかに根深いものだったのだ。

「センサーの弱点を明らかにすることで改善、安全保障につなげていこうというのが狙いです」(井上教授)

もちろん、カメラの画像はモニタリングすれば実際に見ることはできるし、イメージプロセッサーによる認識の状態も確認することはできる。それがわからないとはどういうことか、と思うかもしれないが、ここでいうカメラの能力とはどちらかというと、逆光下や夜間の走行などカメラにとって苦手な極端な条件におけるものを指している。こうした極端な条件で起こり得る事象、パターンをすべて検証できているか把握できているかというと、できていなかった。検証しようにもツールすらなかったのだ。

あらゆる事象、シナリオを網羅的に検証し、問題となり得るような条件を炙り出して、それを定量的に評価することは、実車による走行実験では不可能と思って間違いない。シナリオの数が膨大に過ぎるだけでなく、刻々と表情を変える天候や日照条件のリアル環境では再現性が確保できない。そこで用いられるのがシミュレーションシステムだ。

いまやシミュレーションシステムは珍しいものではないが、じつはカメラの検証ができるようなレベルのものは存在しなかった。最近はゲームなどでも見かける、光の反射や影がリアルなグラフィックは見た目には現実さながらだが、光の反射や影をそれらしく描き込んだだけにすぎない。光源の存在を想定して反射や影の方向を揃えてはいても、決して正確ではないのだ。

「人間は騙せても、カメラを騙すことはできません」(井上教授)

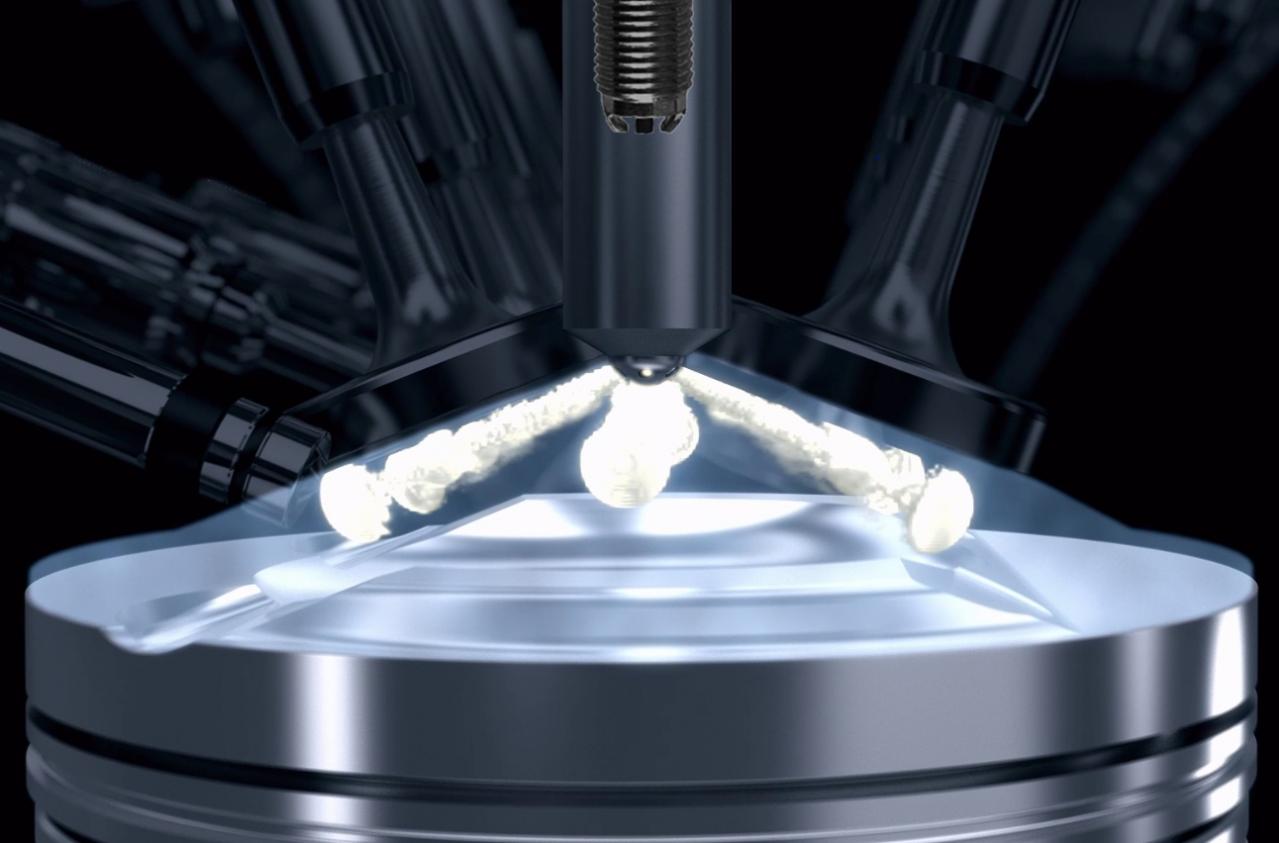

昼間の屋外でいえば光源として太陽が存在し、それを起点とする光線により起きるのが反射であり影である。太陽の位置と光量、そして反射や影を正確に再現しないとカメラの検証にはならない。そのためDIVPでは日照状態をシミュレートする天空環境モデルから構築している。要はカメラというセンサーが検出する光(光線)の振る舞いを再現することに特化した、“超リアル”なシミュレーションシステムである。

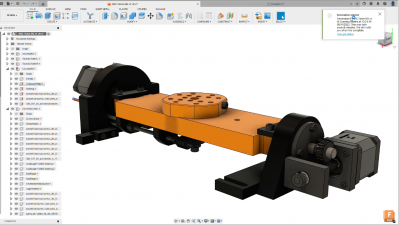

SIPのDIVPプロジェクトにおいて神奈川工科大学が開発を担当しているスクリーン投影型のシミュレーター。基本的には完成車に搭載される実機カメラユニットの持つ認識能力を、車載状態のまま定量的に評価するためのものだが、逆光を再現するほどの光量が望めないなど、その能力には限界があるため、どのような条件(シナリオ)までであればシミュレーターが有効に活用できるのかということを検証する目的でも使われている。

もちろん、バーチャル環境で正確に光を操れても、これをディスプレイに表示、もしくはスクリーンに投影しては、今度はそれぞれの表示能力がボトルネックとなってしまい、正確な再現にならない。例えば逆光を再現しようにも、ディスプレイや(スクリーンに投影する)プロジェクターでは光量が足りない。そこでカメラもモデル化してバーチャル環境上に置く。モデル化したカメラの出力をCS(Iカメラシリアルインターフェース)として取り出して、実機のイメージプロセッサーに入力することも可能だ。イメージプロセッサーは情報抽出のために、さまざまな画像処理を行なうが、この処理は言ってしまえば膨大な画像情報を簡素化することであり、そこでは切り捨てられる情報もあると思って間違いない。どう見えているかを知るためには、イメージプロセッサーの振る舞いもセットで検証する必要があるのだ。